Hoy me anima el ánimo pedagógico (divulgador, incluso vulgarizador) y un objetivo ambicioso. Se está hablando mucho en estos días de lo que en inglés se conoce como Cloud Computing, y que en castellano se acepta habitualmente como Informática en la Nube. Las palabras en sí mismas no aclaran absolutamente nada, sólo son la cobertura verbal y fonética de conceptos complejos. Cualquier referencia meteorológica está fuera de lugar.

Al final me ha salido un artículo muy largo, pero prefiero entregarlo de una vez que dividirlo en varios capítulos. Leedlo por partes, o aquellos que ya conozcáis bien la historia, id directamente a la parte del enchufe.

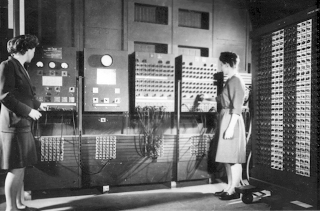

(El ENIAC, con las programadoras Betty Jean Jennings y Fran Bilas, en la Moore School of Electrical Engineering. Fuente: http://www.plyojump.com/classes/mainframe_era.html).

Existen en Internet muchas entradas que describen la historia de la informática, y yo no intento aquí suplirlas. Sin ánimo de ser absolutamente riguroso ni exhaustivo, lo único que pretendo es describir un hilo conductor simplificado (soy consciente de que las cosas han sido y son mucho más complejas de cómo las cuento aquí) que, de modo bastante natural, contra lo que pueda parecer, nos ha llevado hasta aquí. E intentar describir, en modo divulgativo, que resulte comprensible para cualquier no experto, a dónde es que hemos llegado, o que se anuncia que vamos a llegar.

La historia de los ordenadores es del siglo XX. Podríamos ponerle fechas diversas, pero tomemos 1944 (el año de la instalación del ENIAC - Electronic Numeric Integrator And Computer) como un cierto comienzo. De uso básicamente militar, con una capacidad de proceso mínima (en comparación con cualquier portátil de hoy en día), programación por cableado, y toneladas de peso.

Fue en 1951 cuando el primer UNIVAC I se entregó a la Oficina del Censo de Estados Unidos, en lo que podría ser la primera aplicación comercial de los ordenadores.

Los 60 fueron la etapa de desarrollo de los grandes mainframes (el nombre por el que se conoce habitualmente a este tipo de grandes ordenadores monolíticos). Este nombre, con el tiempo, se ha extendido para definir cualquier ordenador de gran potencia, al margen de su arquitectura interna.

Si nos situamos en 1970, por ejemplo, la situación en el mercado real de los usuarios potenciales de la informática (las administraciones públicas, los Bancos, las Compañías de Seguros, los sistemas de Reservas de Vuelos, etc.) correspondía a lo que hoy se denomina como Informática Centralizada. Los clientes potenciales eran, en general, todas las organizaciones que debían manejar miles o millones de datos del mismo tipo. El coste de los ordenadores era enorme (muchos millones de dólares, si lo ponemos en una escala que nos resulte comprensible hoy).

Hay que tener en cuenta que la evolución de la informática se ha producido obedeciendo a tres ejes principales:

1) La evolución del hardware (la chatarra, las máquinas). Es decir, la capacidad de la industria de desarrollar, industrializar y poner a disposición a precios viables, componentes progresivamente más potentes y capaces, procesadores más rápidos, etc.

2) La evolución del software (los Sistemas Operativos, los Programas, las Aplicaciones)

3) La evolución de las comunicaciones.

Por tanto, la evolución real de los recursos disponibles para su uso viable por cualquier empresa u organismo ha tenido siempre que ver con el avance relativo de estos tres factores.

En los 60 y buena parte de los 70, el hardware era muy caro (muy costoso I+D, ventas escasas), y las capacidades de las comunicaciones extremadamente limitadas. Esto provocó la aparición de los llamados Centros de Cálculo. Estos eran empresas que invertían en ordenadores y software, y ponían el servicio a disposición de los usuarios. Habitualmente funcionaban como cajas negras. Es decir, el cliente aportaba los datos en formatos entendibles por el ordenador (cinta perforada, tarjetas perforadas,...), o incluso en papel y era el propio personal del Centro de Cálculo el que se encargaba de traducir los datos en papel a un formato entendible por el ordenador.

Los ordenadores procesaban los datos (las nóminas de una empresa, la gestión de facturación, etc.), y producían un material de salida entendible por los humanos (habitualmente interminables listados impresos).

Para finales de los 70, y definitivamente en los 80, hubo una auténtica revolución en la informática. Primero con la introducción del llamado time sharing, o compartición de tiempo. Utilizando los llamados terminales tontos (dumb terminals) se podía acceder directamente al ordenador. Los terminales estaban ligados al ordenador por conexiones dedicadas (fueran locales mediante cables punto a punto o telefónicas de algún tipo), y tenían una capacidad muy limitada de presentación en pantalla de los datos recibidos del ordenador, y de enviarle los que el usuario introdujera mediante el teclado (o tarjetas perforadas, u otro método). Una de las restricciones era la capacidad en cuanto a flujo de datos que tenían las conexiones. Se intentaba que los datos que circulaban entre el ordenador y el terminal fueran los mínimos, para evitar ralentizar en exceso el proceso.

De esta forma, los clientes podían desligarse de entregar papel, cinta perforada o lo que fuera al Centro de Cálculo, y podía introducir los datos directamente desde terminales instalados en sus propias oficinas. Se reducían intermediarios. Por lo tanto, un cliente cualquiera del Centro de Cálculo utilizaba un porcentaje (habitualmente pequeño) de la capacidad de proceso del ordenador allí instalado. Se compartía el tiempo de proceso disponible.

Se empezaron a producir ordenadores más pequeños pero, al producirse en mayor número, muchísimo más baratos en precio. Se trataba de los llamados miniordenadores, o simplemente minis, en el argot. La capacidad de procesar muchos datos en poco tiempo ya se había convertido en una ventaja competitiva a la que ninguna empresa u organismo que lo hubiera probado podía renunciar. Por ello las grandes corporaciones empezaron a instalar en sus propios locales algún mainframe que, al producirse ya en mayor número, podían tener un precio enorme, pero asequible para algunos negocios. Y empresas más pequeñas pudieron hacer algo equivalente con los minis.

En la práctica, eso fue el final del modelo de negocio de los Centros de Cálculo tal y como se conocieron y proliferaron en los 60 y 70. Las organizaciones se sentían orgullosas de disponer de Informática Propia.

Por esa época había pocas empresas en el mundo con capacidad de producir mainframes (IBM, UNIVAC, Bull, Control Data,...) o incluso miniordenadores (con Digital y HP como nuevos protagonistas, junto a los clásicos).

Los 80 trajeron la aparición de los primeros PC,s (Personal Computer, ú Ordenador Personal). Aportaron a las corporaciones la posibilidad de disponer, junto al usuario, de dispositivos con una capacidad notable de proceso. Ello dió inicio a un movimiento pendular extremo, conocido como Informática Distribuida. La mayoría de corporaciones implantaron una arquitectura de este tipo, con tres niveles habitualmente: los servidores centrales o mainframes, los servidores departamentales (los minis o su evolución), y los ordenadores personales como puestos de trabajo. El proceso total se distribuía entre los tres niveles, intentando limitar la cantidad de datos que debían circular por las conexiones, pues éste seguía siendo un recurso escaso y caro.

Era, y es, cierto que la unidad de proceso en los ordenadores más pequeños era más barata que en los grandes mainframes, y se llegó a creer que podían ser intercambiables. La evolución pendular, primando absolutamente los niveles más próximos al usuario, llevó a los gurús, en torno a 1990, a predecir la desaparición del mainframe en unos pocos años. Como otras predicciones, esta acabó resultando absolutamente falsa. Los mainframes se reinventaron a sí mismos, adaptaron su arquitectura a los nuevos componentes disponibles, para reducir su coste, y han perdurado sin problemas hasta la actualidad, y gozan de excelente salud. Sólo que su aspecto monolítico tiende a desaparecer, y hoy los grandes mainframes disponen de cientos, de miles, hasta de cientos de miles de procesadores trabajando al mismo tiempo. Y utilizan, siempre que es posible, componentes estándar, para beneficiarse en el precio del factor volumen.

La Informática Distribuida (con su arquitectura cliente/servidor de las aplicaciones) acabó creando más problemas de los que resolvía, pues se convirtió en Informática Dispersa, con una complejidad de administración que resultó imposible de mantener con el tiempo, especialmente en las grandes corporaciones.

En paralelo, la evolución de las comunicaciones tomó una imparable carrera ascendente. Las primeras redes IP (interconexión de múltiples ordenadores, atendiendo a ciertos protocolos comunes) sembró la semilla de lo que acabaría siendo Internet ya en el siglo XXI. Los límites al flujo de datos que podían circular por las conexiones aumentó varios órdenes de magnitud, y convirtió en viables arquitecturas que nunca antes se habían podido ni siquiera plantear.

Que el puesto de trabajo para cualquiera de los cientos, miles, decenas de miles de usuarios de una corporación fuera un PC complicaba las cosas, porque cada PC tiene vida propia, y requiere de recursos dedicados a su administración. Es vulnerable al ataque de virus informáticos, y tiene una tendencia ineluctable a degradarse por el uso, por la instalación imparable de toda clase de softwares de usuario, necesarios o no para los fines corporativos.

El navegador como herramienta única de acceso a las aplicaciones corporativas supone una evolución que hoy parece irreversible. Un navegador es una pieza de software sofisticada, capaz de interpretar códigos complejos, que puede aportar capacidades de presentación rica de los datos al usuario, y aporta algunas pequeñas capacidades de control y proceso. La proliferación de estándares y nuevos lenguajes (como el HTML, o Java) permite el diseño de las aplicaciones por bloques u objetos que, combinados mágicamente para formar un todo, permiten poner a disposición del usuario toda la capacidad de proceso del mundo (en el límite), por el simple hecho de tener su PC conectado a la Red. Podemos hablar también de clientes ligeros, que pueden ser submodelos de PC, básicamente sólo con un navegador.

Detrás de esa conexión a la Red hay básicamente tres suministros:

a) Capacidad de proceso, que aportan los mainframes, servidores centrales, servidores periféricos, etc.

b) Capacidad de almacenamiento (seguro) de datos

c) Software (aplicaciones y programas) que permiten al usuario realizar todas las funciones de las que tenga necesidad.

Con una Informática Propia, todos esos suministros se proporcionan desde el interior de la organización. Existe una Red Interna que facilita las comunicaciones a todos los niveles, así como la salida de los usuarios, cuando es necesaria, a Internet para acceder a otros servicios no disponibles en interno (para obtener informaciones necesarias, para reservar sus billetes de avión ú hoteles, etc.). Estaríamos hablando aquí de la Informática en Red, en el sentido de que el puesto de trabajo puede estar conectado a servidores diversos (internos o externos) para las diversas aplicaciones o funciones que requiera.

El paso a la Informática en la Nube supone la sublimación del concepto de enchufe eléctrico. Todos estamos acostumbrados a que cuando conectamos un dispositivo eléctrico a un enchufe, lo que obtenemos es un suministro ordenado (que obedece a ciertas características y requerimientos) que nos da 220V de diferencia de potencial (por ejemplo), con un límite de intensidad en Amperios (para que no salten los fusibles). En la práctica, la bombilla ilumina cuando la enchufamos. El suministro se paga por la suma de dos componentes. El primero es por disponer del servicio, el segundo es proporcional a lo que efectivamente gastamos (es decir, a cuántas bombillas encendemos y por cuánto tiempo).

Lo que hay por detrás del enchufe (centrales de generación eléctrica, redes de distribución de la energía, parques eólicos, placas fotovoltaicas,...) no constituye ninguna preocupación para el usuario, no son su problema. Para él solamente existe el contrato que tiene con una Compañía Eléctrica, y no existe ningún compromiso de que el kilovatio-hora consumido proceda de esa central hidráulica concreta o de ese molino de viento del pueblo de mi cuñado. Es corriente alterna de un cierto voltaje, y con unos límites de consumo predefinidos. Eso es todo.

Cuando un usuario conecta su PC a la red, en el fondo está haciendo sensiblemente lo mismo que cuando enchufa la licuadora a un enchufe. Espera que todo funcione correctamente, que se genere el zumo de fresas y mandarinas (aportadas por el usuario), y que el aparato no se queme ni se destruya.

Con Informática Propia, todos los recursos que se utilizan por el usuario para realizar su trabajo están bajo el control, la supervisión y la administración de algún departamento de la propia Corporación. Lo que provoca que cualquier gran organismo o empresa tenga muchos recursos humanos dedicados a lidiar con un mal necesario, como es la informática, pero que no es el núcleo de su actividad (la Banca, los Seguros, el servicio al Ciudadano,...). Por ello ya ha habido movimientos muy enérgicos en el sentido del outsourcing, o contratación con una empresa externa de un determinado nivel de Servicio Informático. Y si esta tendencia no se ha extendido más y más rápidamente ha sido por la extrema complejidad (jurídica y legal) que tiene este tipo de contratación, que además debe realizarse para plazos muy prolongados, a fin de que sea financieramente viable también para el proveedor.

Pero, si destilamos los activos informáticos que realmente suponen una ventaja competitiva sostenible para cualquier organización, nos quedaremos con solamente dos factores:

1) Las aplicaciones o programas. Hay algunas muy genéricas, e iguales para todo el mundo (los procesadores de texto, las hojas de cálculo, los editores gráficos, etc.). Pero hay otras aplicaciones específicamente ligadas a una actividad concreta, o incluso a una empresa en particular (la gestión tributaria de un país, la gestión de los productos bancarios de millones de clientes, etc.). Disponer de aplicaciones potentes y flexibles, que permitan a la organización poner en el mercado en el mínimo tiempo posible nuevos productos, que les permitan ir siempre por delante de sus competidores, es una ventaja competitiva irrenunciable.

2) Los datos (de clientes, de proveedores, de empleados, de transacciones, de mercados, etc.).

La propia capacidad de proceso no es más que un mal necesario, la que haga falta para que las actividades de la empresa no se vean ralentizadas por su escasez. Y el cómo se aporte esa capacidad (o las tecnologías empleadas) es, desde luego, absolutamente irrelevante a sus objetivos corporativos.

Por lo tanto, si exportamos las aplicaciones y los datos a algún lugar inconcreto de la Red, donde algún suministrador experto dispone de los recursos informáticos necesarios para proporcionar el nivel de servicio contratado y comprometido, ya estaremos en un entorno de Informática en la Nube.

Por supuesto, necesitamos que nuestras aplicaciones corporativas estén disponibles y sean rápidamente adaptables a las nuevas necesidades diarias del negocio. Y mis Datos deben estar permanentemente accesibles y estar seguros, es decir, a salvo de que se pudieran perder o corromper por cualquier contingencia no deseada. Y a salvo de que pudieran ser robados.

Del mismo modo que se desterró el concepto de que cada casa tenga su generador de electricidad (concepto en parte recuperado con las instalaciones fotovoltaicas y demás; la historia es pendular), la capacidad de proceso informático se deportaría a unas pocas compañías expertas en ello, a imagen de las grandes Compañías Eléctricas del mundo.

(Informática en la Nube. Fuente: www.lapstec.com).

Con la disponibilidad de redes de comunicaciones de gran capacidad y rendimiento, que permiten la transmisión prácticamente inmediata de millones de datos a cualquier lugar del mundo, no existe ningún impedimento técnico para poder llevar adelante esta aproximación.

La extensión de esta aproximación permitirá, sin duda, un aprovechamiento mucho más eficiente de los activos informáticos (bastidores llenos de servidores, o de matrices de discos, o de dispositivos de interconexión), ya que los diferentes husos horarios del mundo permiten un porcentaje de utilización de esos activos mucho más elevado de lo que podría conseguir cualquier usuario individual. Es decir, existe un yacimiento de economías de escala tras esta idea.

Los grandes Centros de Proceso de Datos de las corporaciones dedicadas en todo el mundo a prestar este servicio (recuperaríamos el concepto -actualizado- de los antiguos Centros de Cálculo de los 60) podrían instalarse en el lugar del Mundo que fuera más conveniente. Buscando la mano de obra más barata, o los lugares con temperaturas medias más bajas, limitando así el consumo necesario para la refrigeración de tantas máquinas. Es decir, un auténtico ejercicio de globalización informática.

Pero existe un inhibidor importante a esta aproximación, y es el temor pánico al Gran Apagón, así como las complejidades contractuales para poder estar seguros de que el Nivel de Servicio que definamos será exigible efectivamente, y en todo momento. Porque si mis datos se perdieran, o mis aplicaciones dejaran de estar disponibles, ningún tipo de indemnización podría compensarme, pues, posiblemente, el hecho me habría arrojado fuera del negocio. Así de dramáticas son las cosas en este siglo.

Yo mismo, como autor de este blog, lo tengo alojado, de forma gratuita, en Blogger, que forma parte de la gran corporación Google. Y es gratuito porque la corporación obtiene ingresos de otras fuentes, publicitarias y demás. Pero si un día me buscáis en la Red, y mi blog no aparece en unos pocos segundos, desviaréis vuestra mirada hacia otro lado. Seguro que tengo copia de seguridad de todos los artículos que he publicado (¿todos?¿seguro?), y podría reconstruir el blog en algún otro lugar. Volvería a buscaros, e intentar convenceros de que ya todo es como antes, y así seguiría hacia adelante.

Pero si un día Iberia, o Amadeus, o Banco de Santander, o El País, dejan de estar disponibles en la Red, por el Gran Apagón de algún proveedor, el quebranto para su negocio podría llegar a ser insalvable. Y el Apagón podría ser técnico, pero también financiero.

Además, ¿es que hay o puede haber alguien que controle a esas grandes corporaciones?, un Gran Hermano del siglo XXI, que pueda decidir ceder los datos de mis clientes a mi competidor, o que pueda analizar todos los datos de la Nube, y con ello pueda manipular a los individuos de forma, todavía, más eficiente, para orientarles hacia ciertos patrones de consumo, o hacia ciertas conductas.

Creo que solamente las Economías de Escala, a cambio de todas estas inquietudes y angustias, no es motivo suficiente para que se produzca una migración masiva hacia la Informática en la Nube a corto plazo. Es una obligación para cualquier director el reducir los costes, pero no a cualquier precio.

La Informática en la Nube va a coexistir durante muchos años con otras alternativas (la Informática Propia, o el outsourcing dedicado).

Y es que somos de coche propio, más que alquilado. Si podemos mantenerlo, claro.

JMBA

Excelente articulo, como siempre, es que ya nos tienes muy mal acostumbrados a tus buenísimos discursos.

ResponderEliminarMe gustaría agregar que al igual que los jóvenes están dejando a un lado el concepto franquista de tener una casa propia hoy deciden alquilar con lo cual eliminan la famosa carga de la hipoteca y todos sus costes adicionales, hay muchos que optan también por el renting de un coche para eliminar el préstamo bancario para el vehiculo. ¿Porque no tener también un ordenador en el modo de renting? así el mantenimiento y reparaciones del mismo, las aplicaciones, los drivers y demás parafernalia este todo actualizado en tiempo real y sin las complicaciones de los requerimientos mínimos, versiones del SO, espacio en disco, etc. El concepto de la propiedad esta cambiando de arriba a abajo. Tal ves seria mas adecuado decir que estamos cambiando de ser propietarios a vivir y funcionar en una nube. Tendremos todo pero no poseeremos nada, quieras que no eso aporta mucha tranquilidad económica.

Como diría en su tiempo un paradiado Alfonso Guerra: "PAZMAAAAOOO! ME HAS DEJAO PAZMAAAOOO!"

ResponderEliminarEl artículo es muy bueno, va directo al grano, y visualiza muy gráficamente todo lo concerniente a la nube. La introducción a través de su historia es primordial, para entender cómo se ha llegado aquí y por qué.

En mi corta experiencia, cuando he propuesto un sistema de nube para una PYME, ha habido más que chispas, ya que la información de su negocio quiere que esté en sus ordenadores, aunque haya contratos de confidencialidad y de buen uso, y que no tengan técnicos para atender desastres o hacer copias de seguridad. El tema de dónde están los datos es muy susceptible y sensible. Siempre queda el interrogante de: ¿y qué puedes hacer con mis datos? ¿y si hay alguna filtración o una intrusión? ¿y si mañana quiero cambiar de proveedor?

La nube aporta muchas ventajas y elimina muchas barreras, complejidades y costes. Pero cada solución viene acompañada de nuevos problemas.

Rafa, estoy especialmente satisfecho de que el artículo te haya parecido muy bueno, siendo un gran experto en el sector.

ResponderEliminarPero me gustaría también tener alguna reacción de "no iniciados" por verificar y validar si el afán divulgativo ha alcanzado su objetivo para los no profesionales de la informática.

En respuesta a Anónimo (¿quién estará detrás de esta cara en blanco?), es cierto que el renting es una solución alternativa para convertir una inversión en gasto, para convertir una propiedad en un servicio.

ResponderEliminarEn Informática el renting (o leasing, en su caso)existe al margen de la Nube, y es ampliamente utilizado en muchos sectores. Pero la Nube tiene otras connotaciones un poco más desasosegantes, que he tratado de reflejar.

No he hablado, por ejemplo, de otro concepto que es actualmente hype (verborrea no siempre rellena de contenido) en el mercado, que es el SaaS (Software as a Service), porque creo que no aporta nada nuevo al discurso principal, a los efectos de este artículo (presuntamente) divulgativo.

En lo que a mí respecta, ya sólo por su simplicidad en la lectura... Gracias por haberlo lanzado todo "de golpe"; difícil lograr resumir algo más de medio siglo en unas pocas líneas, con lo deprisa que ha ido todo, pero más que conseguido !!!

ResponderEliminarMi apreciación es que en un mundo en el que siempre hay alguien que acaba por demostrar que no hay absolutamente nada que perdure, y que nada (...de nada) es seguro y/o fiable, es difícil que dejemos a un lado la mentalidad del "coche propio", al menos, mientras no seamos contenidos en nuestra propia mentalidad individual.

Creo que de los diferentes inhibidores que expones, el principal no es ya el "Gran Apagón", sino las cuestiones de seguridad en la información.

Es decir, es posible que los sistemas informáticos de las propias empresas también se "apagen", y en mayor medida que bajo una filosofía de Cloud Computing, con los sistemas replicados, etc.; pero el que los datos estén "en las nubes"...

Estoy de acuerdo en que, de momento, convivirá con otro tipo de planteamientos, pero tal vez la situación de crisis actual, cuyas consecuencias durarán varios años, catalice la extensión del "Cloud", al menos, entre cierto tipo de empresas, al obligarles a ser más competitivas (entiendo que lo primero antes de llegar a hundirse en un "apagón" es estar vivo en ese momento...)

En todo caso, y como lo único que parece eterno es tu metáfora del péndulo, ¿qué fuerza lo impulsará hacia el otro lado en el futuro?

Lo dicho, que muchas gracias por el artículo.

Creo que la nube es un concepto bueno, con el argumento de venta de que está disponible 24x7, en cualquier lugar, que no necesitas técnicos para mantenerlo, no te preocupes por las copias de seguridad y todo eso. El trasfondo real es la optimización de beneficios, un negocio muy rentable, en el que muchos clientes utilizan una misma aplicación (más o menos parametrizable), con una inversión ínfima (la de un proyecto estándar, pero con visión industrial, algo así como un molde y una manivela para tirar churros).

ResponderEliminarEstuve trabajando en un proyecto en el que la mayor parte de los ayuntamientos de la Comunidad de Madrid poseen este servicio. Va dirigido a políticos y administrativos, sin conocimientos técnicos. Gracias a nuestro producto, tienen un portal Web fácil de mantener en contenidos (todo a base de una aplicación basada en menús y opciones, y unos formularios (en el fondo tenía un CMS a medida), y una aplicación para la gestión de expedientes administrativos). Para el ayuntamiento, no hay preocupaciones técnicas, ni de máquinas. Es, como bien decías en el post, la empresa eléctrica, a la que te conectas y todo funciona, con tu aportación (contenidos).

Habrá aplicaciones en la nube que tendrán sentido, pues su aplicación es lo que requiera. Según su utilidad, a quién va dirigido, el coste que tenga para el cliente, será éste el rasero de su éxito.

El ejemplo de los ayuntamientos es bueno. Otro ejemplo de lo contrario es lo que comenté en mi anterior comentario. Para una PYME, propuse un sistema de nube, para que esta empresa, y las que lo quisieran, pudieran llevar la gestión de su trazabilidad de alimentos. Parece idílico el argumento de venta que expuse al principio de este comentario. Pero este cliente (y alguno más), se echaron para atrás. La trazabilidad de sus datos es crítico, y aunque le garantices la robustez de la seguridad de los datos, prefieren tenerlo en sus propios equipos, aunque ellos mismos tengan pagar más por una copia de seguridad, o una consulta especial. Quieren tener el poder y el control de su información en casa.

Estimado JMBA,

ResponderEliminarBuenas tardes. Soy Natalia, Responsable de Comunicación de Paperblog. Quisiera disculparme por dejarte un comentario en el blog, pero no he encontrado otra manera de contactarte. Tras haberlo descubierto, me pongo en contacto contigo para invitarte a conocer el proyecto Paperblog, http://es.paperblog.com, un nuevo servicio de periodismo ciudadano. Paperblog es una plataforma digital que, a modo de revista de blogs, da a conocer los mejores artículos de los blogs inscritos.

Si el concepto te interesa sólo tienes que proponer tu blog para participar. Los artículos estarían acompañados de tu nombre/seudónimo y ficha de perfil, además de varios vínculos hacia el blog original, al principio y al final de cada uno. Los más interesantes podrán ser seleccionados por el equipo para aparecer en Portada y tú podrás ser seleccionado como Autor del día.

Espero que te motive el proyecto que iniciamos en Enero con tanta ilusión. Échale un ojo y no dudes en escribirme para conocer más detalles.

Recibe un cordial y afectuoso saludo,

Natalia

Hola de nuevo, Jose María.

ResponderEliminarA tenor de lo interesante de este tema, y visto en otros foros, añado un comentario que incluí otro debate como éste en LinkedIn, y que puede aportar algo más de luz.

El concepto de cloud computing no es nuevo, si bien ahora es cuando se ha consolidado gracias a la evolución de las tecnologías.

Cierto es que habrá oportunidades para algunos, y en otros casos, a los que no sepan aprovecharlas será su tumba. También se vislumbra pocos proveedores de servicios cloud especializados en algún tipo de negocio o de funcionalidad, que se consoliden como líderes en ese sector.

Si bien el cloud computing ofrece muchas ventajas a proveedores y a usuarios, hay ciertos detalles que dificultarán su implantación.

El primero de ellos es la seguridad, pues aunque te la garanticen, por experiencia propia, las PYMES quieren la más absoluta confidencialidad, y no se fian de que sus datos no los tengan en sus máquinas, o que alguien fuera de la empresa pueda acceder a ellos, especialmente si hay contabilidad o finanzas.

El segundo de ellos son las integraciones con otras aplicaciones. Muchas empresas tienen aplicaciones hechas a medida, que se comunican por interfaces con otras. Adoptar un servicio en cloud obligaría al resto de aplicaciones integrarse con dicho servicio, lo que incrementa los costes. Otro problema añadido es el nivel de integración, pues habrá cosas personalizadas que no estén contempladas en el servicio y no puedan integrarse.

El tercero de ellos es que muchos de estos servicios se venden para usarse desde cero. Si tienes una aplicación que se ha usado durante años, no te van a migrar los datos al servicio.

El cuarto, y el más crítico de todos, es depositar una confianza ciega en una tecnología, con un riesgo que impactaría sobre el propio negocio, generando unas pérdidas intangibles. Si un día se produce un apagón en internet, o hay algún problema con un router de internet, o con el host que tenemos contratado, estamos perdidos. En un sistema tradicional, no hay esta dependencia, y el negocio sigue funcionando, pues las máquinas al estar físicamente dentro de la empresa, funcionan en red interna, se pueden hacer backups y restaurarlos en otras máquinas, etc.

Creo que cloud computing tendrá éxito en sectores no críticos, o en aquellos escenarios en el que las empresas puedan costearse sus propias infraestructuras cloud (cloud privado). No es la panacea, aunque sí un avance significativo, que habrá que adaptar con sentido común.